米尔RK3576边缘计算盒精准驱动菜品识别模型性能强悍

2025-10-30

48

来源:米尔电子

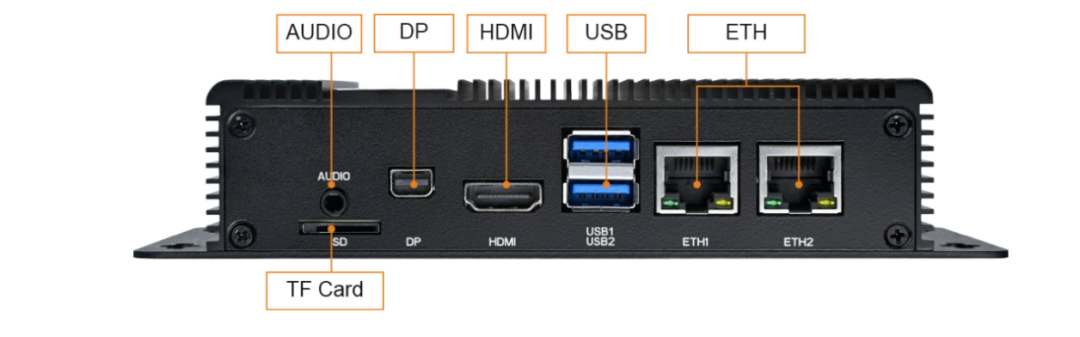

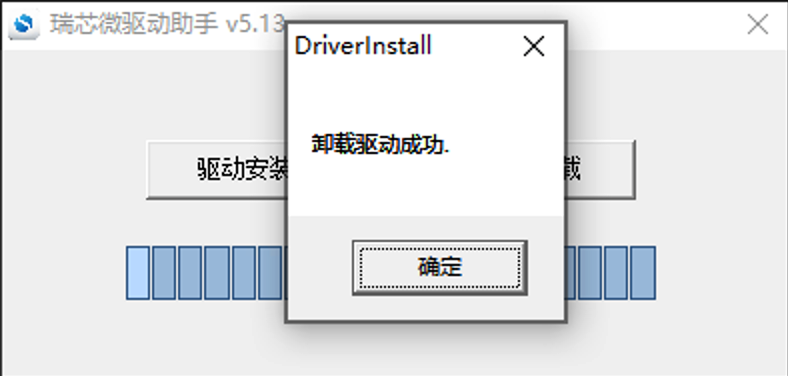

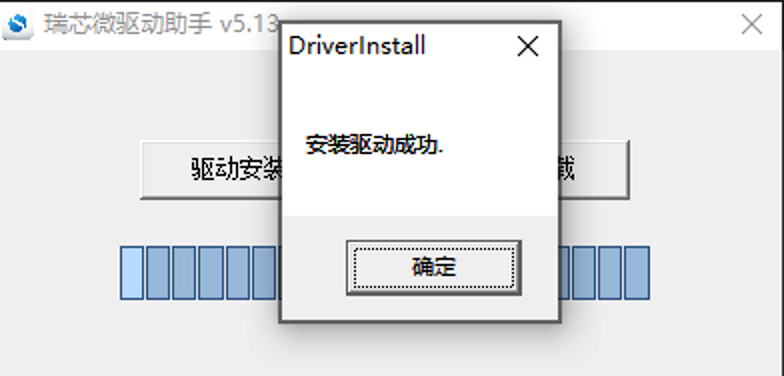

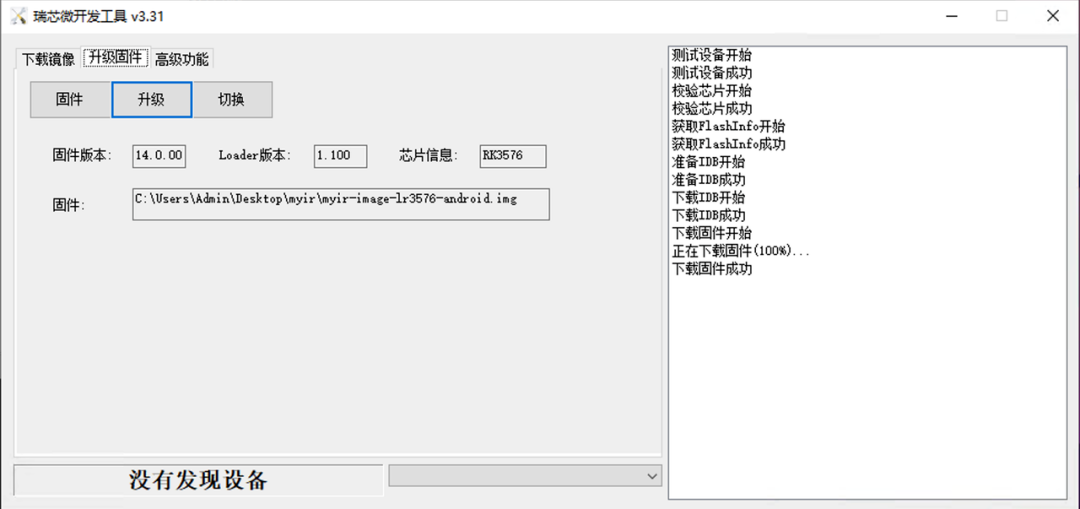

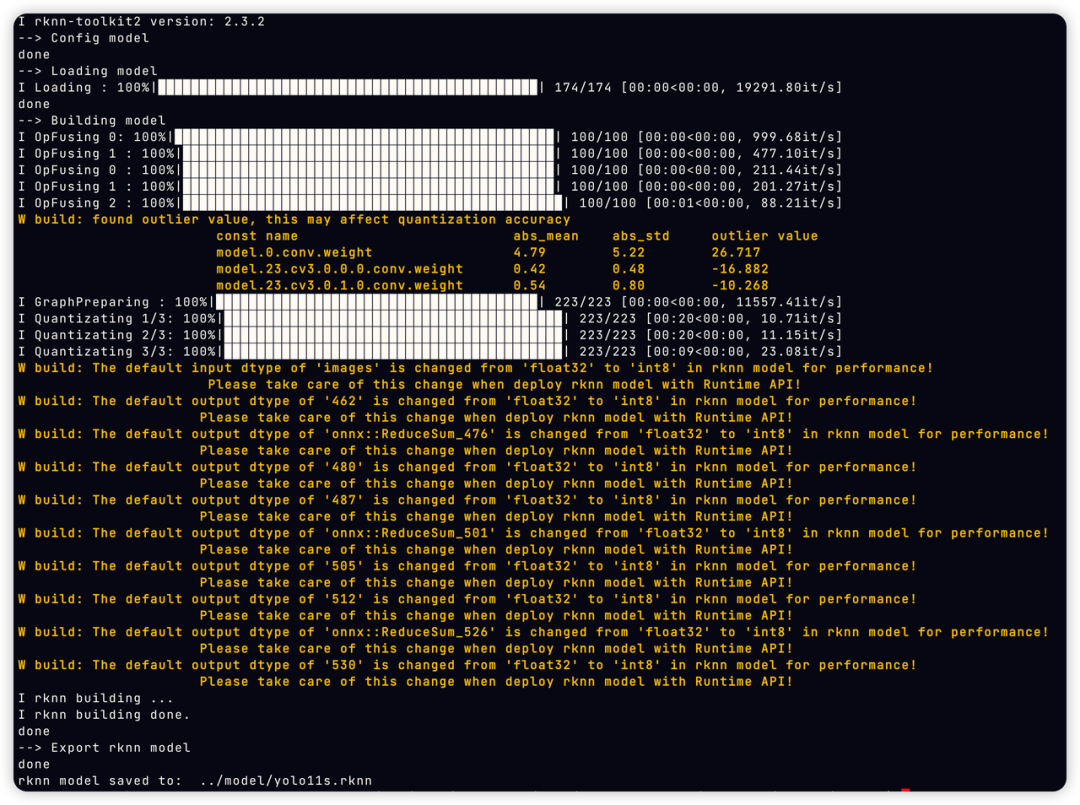

在人工智能与边缘计算深度融合的今天,将AI模型高效部署于终端设备已成为产业智能化的关键。本文将分享基于米尔MYD-LR3576边缘计算盒子部署菜品识别安卓Demo的实战经验。该设备凭借其内置的强劲瑞芯微RK3576芯片,为视觉识别模型提供了充沛的本地AI算力,成功将“智慧识菜”的能力浓缩于方寸之间,充分证明了其作为边缘AI应用坚实载体的卓越性能与可靠性。 本文以米尔电子的MYD-LR3576边缘计算盒子为例,讲解如何在Android平台部署yolo11s、PPLCNETV2模型实现实时菜品识别。为开发者与研究者提供一份兼具实践参考与技术洞察的模型端到端的部署指南。 产品标配8GB LPDDR4X内存与64GB eMMC存储,支持双千兆网口、WiFi 6、多路USB 3.0及4K显示输出,提供完整的Debian/Linux软件开发环境。 凭借其高性能NPU与丰富接口,该设备可高效支撑计算机视觉、智能分析等边缘AI场景,为菜品识别、工业质检等应用提供稳定可靠的硬件平台。 要将YOLOv11s、PPLCNetV2等主流AI模型高效地部署在MYD-LR3576-B这样的边缘设备上,并充分发挥其NPU的算力,离不开一个关键的软件工具链——RKNN-Toolkit2。这是由瑞芯微官方提供的核心SDK,专为其RK系列芯片的NPU(神经网络处理单元)设计。 GitHub仓库: https://github.com/airockchip/rknn-toolkit2 RKNN-Toolkit2是一个功能完整的模型转换、推理和性能评估工具包。它的核心作用在于充当一个“翻译官”和“优化器”,将开发者们在主流深度学习框架(如PyTorch, TensorFlow, ONNX等)上训练好的模型,转换成可以在瑞芯微NPU上高效运行的专用格式——RKNN模型。 该工具链为AI模型在边缘端的部署提供了全流程支持: 1. 模型转换 2. 仿真推理与精度分析 3. 性能评估 4. 跨平台部署支持 在本文的菜品识别Demo中,正是利用了RKNN-Toolkit2的强大能力: 总结而言,RKNN-Toolkit2是释放MYD-LR3576-B内部6 TOPS NPU潜力的钥匙。 它大大降低了开发者将AI模型部署到瑞芯微边缘计算平台的技术门槛和开发周期,使得构建像实时菜品识别这样的高性能AI应用变得简单而高效。 RKNN Model Zoo 是一个专为瑞芯微NPU打造的 “模型商店” 或 “开箱即用模型库” 。该项目收集了大量经典的、高性能的深度学习模型,并已经过预转换和调优,直接提供了现成的 RKNN格式模型文件,同时附带了完整的示例代码。 Github地址:https://github.com/airockchip/rknn_model_zoo RKNN Model Zoo优点: 米尔的MYD-LR3576边缘盒子默认是Linux系统,在我们的场景中,需要先刷机为Android系统。 登录米尔开发者中心(https://dev.myir.cn/auth/login.html),在开发者平台注册绑定产品信息,在包装盒侧面会有一个产品型号系列号,可通过微信扫码绑定。 绑定成功后,依次点击我的产品->软件资料->Android14操作系统: 然后复制提取码后点击“阿里云盘”字样即可打开米尔提供的所有相关资料文件。如: 是我们需要的文件,分别是软件开发指南、安卓系统镜像文件以及工具,下载上述文件。 在软件开发指南中的第四章有详细的镜像编译步骤,开发者可以根据情况自行编译镜像,方便进行自定义。本文直接使用了资料中已经编译好的Android镜像进行烧录。 1. 安装驱动 驱动安装工具压缩包位于 03-Tools/DriverAssitant 目录下,解压运行 DriverAssitant工具,出现以下界面,首先点击卸载驱动,然后点击驱动安装: 2. 烧录镜像到EMMC RKDevTool是瑞芯微提供的适用于 RK 系列芯片的 windows 下的便捷开发工具,为开发人员提供了固件烧录/镜像烧录|设备擦除|设备切换/固件解包等功能。 注意:这里的操作是在另外一台电脑上操作,并且已经配置了python环境或Conda环境。为模型转换、量化以及测试提供基础环境。 1. 可以直接通过网络安装: 2. 通过本地 wheel 包安装 首先克隆RKNN-Toolkit2项目文件: 或者手动下载下面涉及到的文件。 然后进入项目根目录后: rknn_model_zoo中包含了很多官方已经适配的模型,包括模型训练以及模型转换脚本。 rknn_model_zoo中已经包含了yolo全系列模型,因此yolo11模型的转换非常简单,我们直接将训练好的模型(通常是.pt格式)先转为onnx格式。该转换过程通常建议在与训练模型相同的环境中进行,如何进行yolo11的模型训练不是本文重点,可参考: https://github.com/airockchip/ultralytics_yolo11 进行训练。 转换命令: 执行完毕后,会生成 ONNX 模型。假如原始模型为 yolo11s.pt,则生成 yolo11s.onnx 模型。 然后进入rknn_model_zoo项目根目录,再依次进入examples/yolo11/python路径下,有一个python转换脚本:convert.py,可通过python convert.py 查看脚本帮助文档: 根据文档可知,脚本的第一个参数是要被转换的onnx模型路径,第二个参数是平台,即SOC型号,第三个参数是量化相关,我们的平台是rk3576,如果量化则选i8,不量化则选fp。我们这里选择量化: ⚠️ 选择量化需要准备校准数据,读取的数据路径在脚本中已经固定为../../../datasets/COCO/coco_subset_20.txt,这里需要修改为我们自己的数据,数量建议至少20张。 转换成功后可看到: 脚本默认将转换后的模型存储在../model中。 PPLCNETV2网络是Paddle提供的,因此需要使用paddle2onnx工具,先将paddle格式转为onnx格式: 由于RKNN官方没有PPLCNET模型的Demo,因此我们需要自己根据模型转换的API文档编写rknn模型的转换脚本,可复制一份Yolo11的转换脚本进行修改,重点修改模型的输入输出形状、归一化参数等。然后参考yolo11的转换命令进行转换。 本章将详细介绍基于米尔MYD-LR3576边缘计算盒开发的菜品识别安卓Demo应用。该案例完整展示了从特征库构建到实时识别的全流程,充分体现了设备在端侧AI应用中的实用性与高性能。 特征注册是构建可扩展菜品识别系统的关键第一步,其目的是为系统创建一个本地的、可定制的菜品特征库。 该设计的优势在于:用户无需重新训练庞大的深度学习模型,仅需提供数十张示例图片,即可快速、灵活地扩充或修改系统所能识别的菜品库,极大地提升了应用的实用性和适应性。 Demo提供了三种识别模式,以适应不同场景下的需求: 用户可以直接调用设备摄像头,现场对菜品进行拍照。拍完后,系统立即对照片进行识别,并绘制识别结果。 用户可以从手机相册中选择已有的菜品图片进行识别。 Demo启动设备摄像头并开启实时预览,视频流中的每一帧都会被送入识别流水线。系统能够连续、不间断地进行识别,并将结果实时覆盖显示在视频画面上,提供流畅的“所见即所识”体验。 无论采用哪种识别模式,其核心的识别流水线是相同的,并且都得益于MYD-LR3576强大的NPU算力: 1. 目标检测: 当一张图片或视频帧输入后,首先由 YOLOv11s模型进行推理。它的任务是精准定位图片中菜品所在的位置,并输出其边界框,为后续处理划定了关键区域。 2. 特征提取: 系统将YOLOv11s检测出的菜品区域裁剪出来,并送入 PPLCNetV2特征提取模型中,生成该区域的特征向量。 3. 特征比对: 最后,系统将这个新生成的特征向量与特征注册阶段建立的数据库中的所有已知特征向量进行相似度计算(通常使用余弦相似度)。找出相似度最高的已知菜品,并将其名称作为识别结果输出。 性能亮点: 在MYD-LR3576上,经过RKNN-Toolkit2优化后,YOLOv11s和PPLCNetV2这两个模型在NPU上的单次推理时间均稳定在20ms左右,这确保了即使在最耗费资源的实时视频流模式下,系统也能保持较流畅的识别帧率。 为了量化识别系统的可靠性,Demo还内置了准确率评估功能。用户可以选择一个包含已标注图片的测试集,系统会自动运行批量识别,并将识别结果与真实标签进行比对,最终生成一份包含准确率等关键指标的评估报告,为模型优化和特征库完善提供了数据依据。 该菜品识别Demo仅实现了基础功能,且没有做针对性优化,如所有操作都是同步进行,即摄像头数据获取或读取本地图像->格式转换->色彩空间转换->预处理->模型推理->结果后处理这一整套流程都是同步进行,且模型推理时仅使用了一个NPU核心(共两个),如果使用NPU进行图像处理并配合图像队列异步处理以及充分利用NPU核心,其性能可以达到15-20帧。即便Demo没有针对优化,RK3576的性能同样足够支撑端侧复杂AI流水线的能力。从高效的特征注册到实时的多模型推理,其强劲的NPU算力是实现所有功能流畅运行的基石,为智慧餐饮等领域提供了可靠的硬件解决方案。 MYD-LR3576-B边缘计算盒:❝

❝

1. 基本介绍

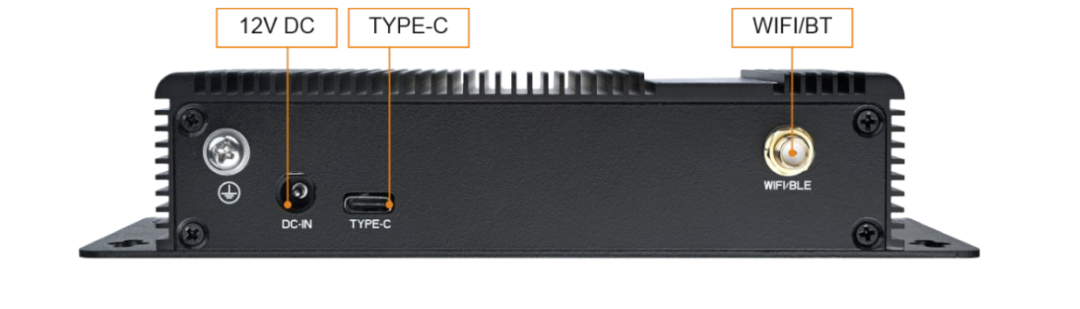

1.1 边缘计算盒

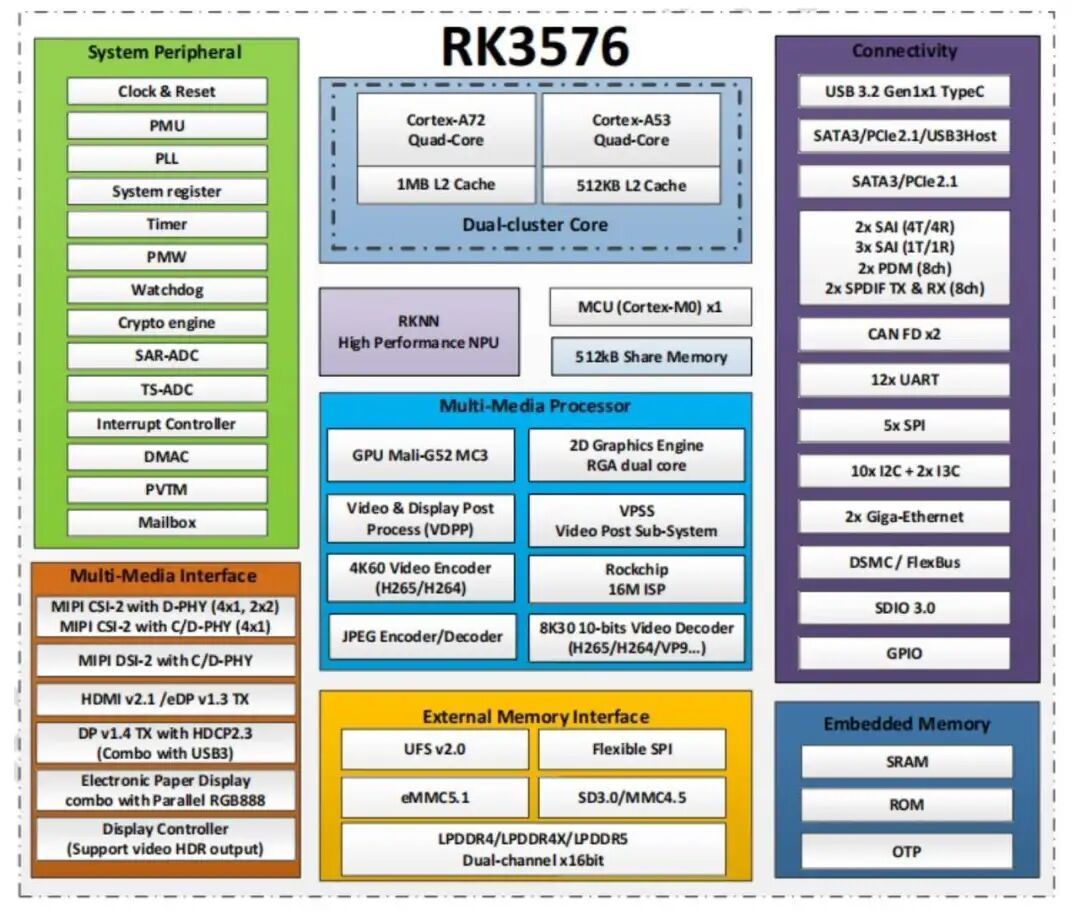

米尔MYD-LR3576-B边缘计算盒是一款基于瑞芯微RK3576处理器设计的高性能嵌入式AI设备。 该处理器集成八核CPU架构(4×Cortex-A72 + 4×Cortex-A53)与算力达6 TOPS的NPU(2核心),具备强大的边缘端AI推理能力。

米尔MYD-LR3576-B边缘计算盒是一款基于瑞芯微RK3576处理器设计的高性能嵌入式AI设备。 该处理器集成八核CPU架构(4×Cortex-A72 + 4×Cortex-A53)与算力达6 TOPS的NPU(2核心),具备强大的边缘端AI推理能力。

1.2 RKNN-Toolkit2 SDK

1.2.1 RKNN-Toolkit2 是什么?

1.2.2 核心功能与工作流程

1.2.3 与MYD-LR3576的完美协同

1.3 RKNN Model Zoo

2. 搭建环境

2.1 刷入Android系统

2.1.1 获取资料

01-Docs(ZH)/MYD-LR3576-GK Android 软件开发指南-V1.0.pdf

02-Images/myir-image-lr3576-android14.zip

03-Tools2.1.2 镜像烧录

2.2 准备RKNN-Toolkit2环境

❝

pip install rknn-toolkit2 -i https://pypi.org/simple

# 如果已安装 RKNN-Toolkit2,可通过以下命令升级 RKNN-Toolkit2

pip install rknn-toolkit2 -i https://pypi.org/simple --upgradegit clone https://github.com/airockchip/rknn-toolkit2.git -d 1 # 请根据不同的 python 版本及处理器架构,选择不同的 requirements 文件:

# 其中 cpxx 是 python 版本号

pip install -r packages/arm64/arm64_requirements_cpxx.txt

# 安装 RKNN-Toolkit2

# 请根据不同的 python 版本及处理器架构,选择不同的 wheel 安装包文件:

# 其中 x.x.x 是 RKNN-Toolkit2 版本号,cpxx 是 python 版本号

pip install packages/arm64/rknn_toolkit2-2.3.2-cp310-cp310-manylinux_2_17_aarch64.manylinux2014_aarch64.whl3. 模型转换

3.1 yolo11模型转换

# 调整 ./ultralytics/cfg/default.yaml 中 model 文件路径,默认为 yolo11n.pt

# 在 ultralytics_yolo11 的项目根目录执行

export PYTHONPATH=./

python ./ultralytics/engine/exporter.pypython convert.py

Usage: python3 convert.py onnx_model_path [platform] [dtype(optional)] [output_rknn_path(optional)]

platform choose from [rk3562, rk3566, rk3568, rk3576, rk3588, rv1126b, rv1109, rv1126, rk1808]

dtype choose from [i8, fp] for [rk3562, rk3566, rk3568, rk3576, rk3588, rv1126b]

dtype choose from [u8, fp] for [rv1109, rv1126, rk1808]❝

python convert.py onnx模型路径/yolo11s.onnx rk3576 i8

3.2 PPLCNETV2模型转换

paddle2onnx

--model_dir models/

--model_filename inference.pdmodel

--params_filename inference.pdiparams

--save_file paddle_feature_one_batch.onnx

--opset_version 11

-isd "{'x':[ 1, 3, 320, 320 ]}"4. 菜品识别案例

4.1 特征注册

4.2 菜品识别

4.2.1 拍照识别

4.2.2 本地图片识别

4.2.3 实时视频流识别

4.3 识别流水线与性能表现

4.4 准确率评估功能

4.5 案例总结

2025-10-30

米尔RK3576边缘计算盒精准驱动菜品识别模型性能强悍

❝在人工智能与边缘计算深度融合的今天,将AI模型高效部署于终端设备已成为产业智能化的关键。本文将分享基于米尔MYD-LR3576边缘计算盒子部署菜品识别安卓Demo的实战经验。该设备凭借其内置的强劲瑞芯微RK3576芯片,为视觉识别模型提供了充沛的本地AI算力,成功将“智慧识菜”的能力浓缩于方寸之间,充分证明了其作为边缘AI应用坚实载体的卓越性能与可靠性。❝本文以米尔电子的MYD-LR3576边缘

2025-10-30

米尔与安路联合亮相VisionChina 2025,共推FPGA视觉方案

2025年10月28日,由机器视觉产业联盟主办的“2025深圳机器视觉展暨机器视觉技术及工业应用研讨会(Vision China)”在深圳国际会展中心(宝安)9号馆隆重启幕。展会以“VISION+AI赋能电子制造升级”为主题,聚焦人工智能与机器视觉技术在电子制造全产业链中的融合与创新,集中展示AI技术在提升视觉系统能力、突破行业应用瓶颈方面的前沿成果与解决方案。米尔电子应安路科技的邀请出席此次盛会

2025-10-23

经典再进化:米尔ZYNQ 7010/7020全面适配2024.2工具链

在工业物联网、机器视觉和智能网关等严苛领域,米尔电子的MYC-C7Z010/20-V2与MYC-Y7Z010/20-V2核心板及开发平台,凭借其硬核特性,已成为众多企业信赖的首选方案。我们深知,卓越的硬件平台需要匹配敏捷、高效且安全的软件工具链。为应对开发者对先进工具与日俱增的需求,并前瞻性地响应全球日益严格的网络安全法规,我们对经典的ZYNQ 7010/7020产品进行一次里程碑式的软件生态升级

2025-10-16

从微秒级响应到确定性延迟:深入解析米尔全志T536核心板的实时性技术突破

各位工程师同仁,今天咱们聊点硬核的——实时性。这不是那种"差不多就行"的性能指标,在工业控制、机器人运动、电力保护这些领域,实时性就是生命线。想象一下:工业机器人抓取精密元件时,哪怕几毫秒的延迟都可能导致良品率暴跌;电力系统故障检测,响应慢了几个毫秒可能就是一场灾难。为什么通用Linux在实时场景中"力不从心"?标准Linux内核设计初衷是"公平调

2025-10-16

米尔电子获全志科技生态认证,共推工业智能化升级

在近日举办的2025中国国际工业博览会上,米尔电子被全志科技正式授予“生态认证合作伙伴”证书,标志着双方在嵌入式处理器模组领域的合作迈入新阶段。此次认证基于米尔电子在T536、T527、T113等全志工业级核心板及开发板被市场的高度认可,米尔电子的全志系列产品已广泛应用于工业自动化、机器人及边缘计算场景。米尔代表领取“生态认证合作伙伴”证书(右三)生态共建:全产业链协同创新全志科技通过“芯片+

2025-10-16

名单揭晓,追加30套开发板!米尔-安路飞龙派「硬核创造力」第二季

经过米尔电子和安路科技的严格筛选,30位「硬核玩家」从千帆竞逐中脱颖而出,正式成为米尔-安路飞龙派第二季创意秀的玩家。开发者们将以MYD-YM90X开发板为起点,开启一场FPGA的盛宴,在安路飞龙派的赛道上探索无限可能!现将入选的30位开发者/团队名单公布如下(排名不分先后):

2025-09-26

颂歌迎国庆丨米尔电子国庆节及中秋放假通知及温馨提示

金风送爽,秋桂飘香,阖家欢聚,共庆国昌。我们即将迎来中秋佳节及祖国76周年华诞。在这美好的金秋时节,在这家国同庆之际,米尔全体员工衷心感谢您长期以来的信任和支持,预祝您节日快乐!·国庆放假时间·一二三四五六日29初八30初九1国庆2十一3十二4十三5十四6中秋7十六8十七9十八10十九11二十12廿一10月1日 至 10月8日,共放假8天根据《国务院办公厅关于2025年部分节假日安排的通知》相关内

2025-09-26

如何移植EtherCAT Igh--基于米尔RK3576开发板

本文将介绍基于米尔电子MYD-LR3576开发板(米尔基于瑞芯微 RK3576开发板)的板端移植EtherCAT Igh方案的开发测试。摘自优秀创作者-EPTmachine米尔基于瑞芯微RK3576开发板EtherCAT IgH需要保证高实时性,Preempt-RT是一种针对实时性能进行了优化的Linux内核。与普通的Linux内核相比,Preempt-RT具有以下优势:实时性能: Preempt

2025-09-18

追加!30套FPGA开发板免费送!米尔-安路飞龙派创意秀活动再开启

大赛简介日前,米尔电子2025年举办的米尔-安路飞龙派FPGA/FPSoC创意开发大赛圆满落幕,吸引了众多工程师踊跃参与。为持续推动技术创新,米尔电子现重磅推出第二期福利活动——基于安路DR1M90开发板的创意秀,再次免费赠送30套FPGA开发板,旨在鼓励工程师突破思维边界,通过实践探索安路飞龙派产品的无限可能,为创新应用提供强力支持。报名条件:用户需关注米尔电子公众号;第一期已领开发板的用户不可

2025-09-11

“一芯四用”,米尔RK3576如何同时驾驭4路YOLOv8视频流?

在科技飞速发展的当下,人工智能与边缘计算的融合正以前所未有的速度重塑着我们的生活。RK3576芯片拥有4核Cortex-A72以及4核Cortex-A53提供基础算力,6TOPS算力NPU来模型推导运算。使用YOLOv8模型时也是手到擒来,接下来随着步伐看看它表现如何。YOLO简介YOLO(You Only Look Once)是当前业界领先的实时目标检测算法系列,以其速度和精度的完美平衡而闻名。